Szacunkowy czas na przeczytanie artykułu: 11 minut.

Każdy sklep internetowy, zarówno ten który dopiero stawia swoje pierwsze kroki w e-commerce, jak i ten który funkcjonuje od wielu lat ma cele, do których dąży. Aby mógł realizować założone cele w jak największym stopniu, sklep powinien być jak najbardziej przyjazny i użyteczny. Jak zatem znaleźć rozwiązania, które będzie najlepsze dla Użytkowników? Z pomocą przychodzą testy A/B.

Preferencji Użytkowników nie da się przewidzieć i tylko przeprowadzenie testów A/B pozwala to sprawdzić i mieć pewność popartą konkretnymi danymi, a nie tylko domysłami. Testy A/B zyskują coraz bardziej na popularności. Do tego stopnia, że część firm nie tylko przeprowadza pojedyncze testy, ale także tworzy ich strategię. Ustalane są konkretne cele strategiczne, które łączy są z odpowiednimi testami A/B. W ten sposób niektóre firmy mają zaplanowane testy nawet na kilka lat.

Czym są testy A/B?

Testy A/B to metoda, w której porównywane są różne warianty danego elementu sklepu internetowego, po to by znaleźć ustalić:

- który z nich jest najlepszy dla Użytkowników (najbardziej przyjazny i funkcjonalny) oraz

- który w większym stopniu realizuje postawione mu cele biznesowe.

Niekiedy testy te nazywane są także testami A/B/n, ze względu na możliwość porównywania większej ilości wariantów e-sklepu. Opcja A jest tą pierwotną, w stosunku do której porównuje się pozostałe. Natomiast opcje od B do n są tymi testowanymi. Mogą różnić się pomiędzy sobą tylko jednym elementem (na przykład lokalizacją zdjęć na stronie) lub większą ich ilością. Zdarza się, że testowane warianty od B do n są całkowicie odmienne od wariantu A.

Podczas przeprowadzania testów A/B wszystkie warianty badane są w tym samym czasie, po to by wykluczyć wpływ innych czynników. Dzięki testom A/B jesteśmy w stanie stwierdzić, czy wprowadzenie określonych zmian na stronie przyczyni się do wzrostu konwersji i przychodów, czy też lepiej pozostawić aktualną wersję e-sklepu.

Co można porównywać w testach A/B?

Porównywać można wiele elementów, np.: różne teksty (zarówno treści, jak i ich kolorystykę, rozmieszczenie, itd.), kolory na stronie, rozmiary i komunikaty Call to Action, rozmieszczenie elementów na stronie, ukrywanie informacji lub ich wyświetlanie, mniejsze/większe eksponowanie poszczególnych elementów na stronie (na przykład: filtrowania, sortowania, ceny, wysyłki) oraz wiele innych. Tak naprawdę można przetestować praktycznie każdy element na stronie.

Warto przeprowadzać testy A/B?

Zdecydowanie tak! Dlaczego? Stosunkowo niewielkimi nakładami czasu oraz pieniędzy możesz otrzymać coś bardzo cennego – wiedzę! A dokładnie wiedzę na temat tego, czy maksymalnie wykorzystujesz możliwości strony lub czy dany sklep internetowy jest w stanie wygenerować większą konwersję oraz przychody. Ale przede wszystkim poznajesz preferencje swoich klientów.

Jednak czy zawsze warto je przeprowadzać? Warto, gdy nie wiemy czegoś na pewno, a jedynie podejrzewamy. Na przykład gdy domyślamy się, że dany element na stronie jest pozytywnie odbierany przez Użytkowników i wydaje nam się, że korzystnie wpływa na konwersję, jednak nie mamy żadnych danych, które to potwierdzą. Przeprowadzenie testów A/B da pewność, czy wspomniany element faktycznie działa na naszą korzyść.

Czytaj również: Czym jest Progresive Web App?

Ile kosztuje przeprowadzenie testów A/B?

Koszt przeprowadzenia testów A/B jest różny, w zależności od stopnia zaawansowania, ilości testowanych elementów. W przeliczeniu na roboczogodziny może się to wahać od kilkunastu do nawet kilkudziesięciu godzin. Może się wydawać, że to dużo. Jednak patrząc na korzyści, jakie otrzymamy w zamian – dane, które pozwolą nam w jeszcze większym stopniu zoptymalizować stronę lub sklep internetowy, a także zwiększyć konwersję – zdecydowanie nie jest to wygórowana cena. Tak naprawdę stosunkowo niewielkim kosztem otrzymujemy bardzo wartościową wiedzę!

Czy testy A/B są wiarygodne?

Aby test był ważny pod kątem matematycznym i statystycznym, musisz dysponować odpowiednią ilością danych. Na każdą testowaną opcję powinno przypadać ok. 90 000 sesji w ciągu miesiąca. Dlatego też e-sklepy z mniejszym ruchem powinny ograniczać testy A/B do jednej lub dwóch wersji testowych. Te większe mogą sobie pozwolić na testowanie większej ilości opcji.

Tym, o czym warto także pamiętać jest to, by testy A/B przeprowadzać nie dłużej niż przez miesiąc. W dłuższym okresie, może się zmienić wiele czynników: warunki na rynku, ceny, sezonowość, zachowanie użytkowników, zmienia się także sama branża. Wtedy też wyniki otrzymane w testach mogą być niemiarodajne.

Co ważne, badania powinny obejmować pełne tygodnie, bo różne czynniki mogą zmieniać się w zależności od dnia tygodnia. Przykładowo, w poniedziałek Użytkownicy są mniej skłonni do dokonywania zakupów, natomiast chętniej robią je pod koniec tygodnia.

Trudnością, która pojawia się przy testach A/B jest także to, by użytkownikowi któremu została wyświetlona już jedna wersja, w momencie kiedy innego dnia wejdzie na tę samą stronę, ponownie została wyświetlona ta sama wersja (tylko wtedy otrzymane wyniki będą miarodajne).

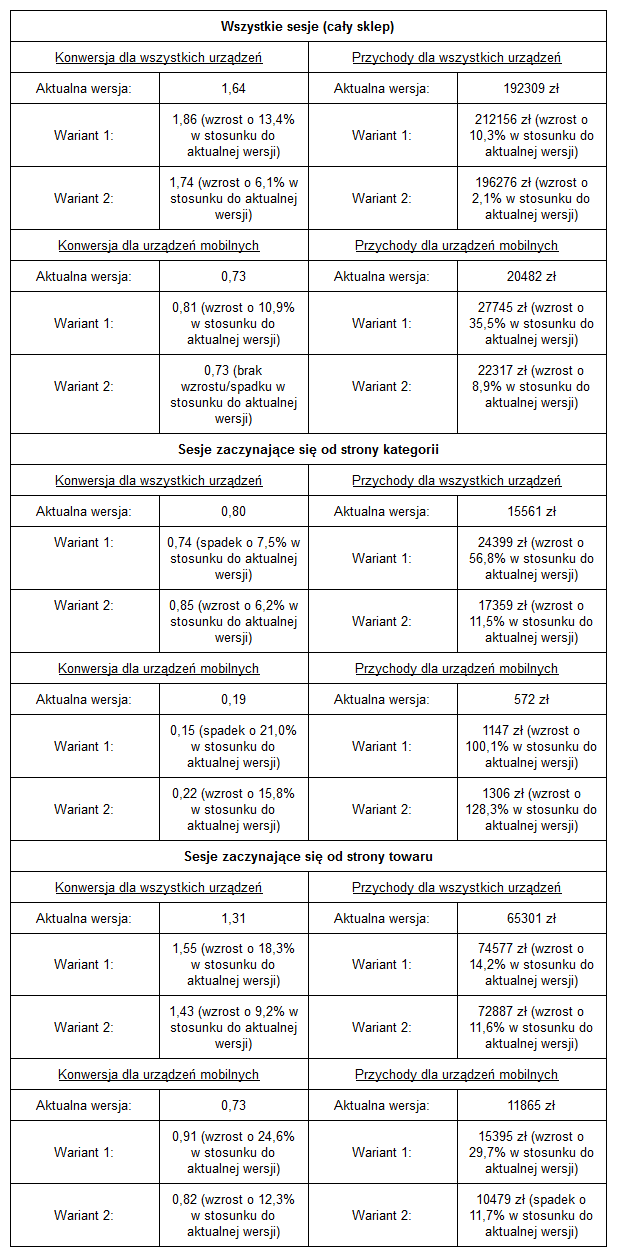

Samo przeprowadzenie testów A/B jest ważne, jednak równie istotna jest odpowiednia analiza ich wyników. Może się okazać, że dla wszystkich urządzeń wprowadzona zmiana będzie odnotowywała wzrosty, ale już dla jednego urządzenia (które jest kluczowe w danym e-sklepie) odnotowywane są spadki. Analiza wyników przeprowadzonych badań powinna obowiązkowo obejmować wszystkie aspekty.

Stopień zaawansowania testów A/B

W zależności od zapotrzebowania testy A/B mogą być proste lub bardziej zaawansowane.

Pierwszy rodzaj testów można przeprowadzić na przykład przy użyciu Google Optimize. Poprzez to narzędzie w kilku krokach można ‘wyklikać’ projekt testu A/B, który ma zostać zrealizowany. Wtedy w teście wersja oryginalna porównywana jest z wersją, która jest sprawdzana. Wersja do porównania może być jedna lub więcej, a to która będzie pokazana danemu użytkownikowi dobierane jest w sposób losowy. Narzędzie Google Optimize udostępnia zaawansowane raporty, na podstawie których możesz wyciągnąć wnioski, która z badanych wersji najlepiej konwertuje. W oparciu o te wyniki możesz się dowiedzieć, czy zmiana wprowadzona na stronie jest faktycznie dobra, czy nie.

Co można przetestować przy użyciu Google Optimize?

Na przykład: kolory na stronie, nazwy obiektów, treści lub grafiki. Google Optimize pozwala na uzyskanie wartościowej wiedzy, ale posiada też pewne minusy. Mianowicie, po ustawieniu testów i włączeniu testowanej strony najpierw ładuje się oryginalna wersja, a dopiero po chwili wersja, która jest testowana. Zmiana ta nie trwa długo (około sekundy), jednak czujne oko użytkownika jest w stanie to zauważyć. Zwłaszcza jeżeli testowana zmiana zlokalizowana jest w górnej części strony.

Czytaj również: Analiza przedwdrożeniowa w e-commerce

Samo narzędzie Google Optimize jest proste w użyciu. W kilku kliknięciach, poprzez intuicyjny interfejs, można ustawić test A/B. Jednak poprzez to rozwiązanie można edytować i testować jedynie styl i HTML, natomiast nie ma możliwości przetestowania elementów, w których zmieniają się dane. Dodatkowo te proste testy A/B można realizować wyłącznie na jednej stronie. Jeżeli chcielibyśmy przetestować dany element na każdej stronie towaru w sklepie, potrzebne są już bardziej zaawansowane testy.

Testy A/B u jednego z naszych klientów – jak to zrobiliśmy?

Test, który opisujemy poniżej, to test na stronie towaru. Przygotowując go wzięliśmy pod uwagę rekomendacje od Google na temat user experience sklepów internetowych. Badaniu poddaliśmy kilka elementów, tj.: zdjęcia oraz video, a także cenę, która została umieszczona w dwóch miejscach na karcie produktu. Właśnie ta zmiana okazała się być kluczowa. Chcieliśmy sprawdzić, który z badanych wariantów jest najbardziej optymalny, który najlepiej konwertuje i generuje największe przychody.

Na potrzeby przeprowadzenia testów A/B w obu testowanych wersjach wprowadziliśmy zmiany w sposobie wyświetlania zdjęć oraz video. Zależało nam na tym, by w jednym module wyświetlać obydwa formaty. Połączenie tych dwóch bibliotek tak by sprawnie to działało nie było łatwe, ale ostatecznie się udało (video wyświetlane jest jako osobna miniatura). W kontekście zdjęć zmieniliśmy także orientację slidera z pionowej na poziomą. Wcześniejsza orientacja znacznie utrudniała przewijanie strony na urządzeniach mobilnych.

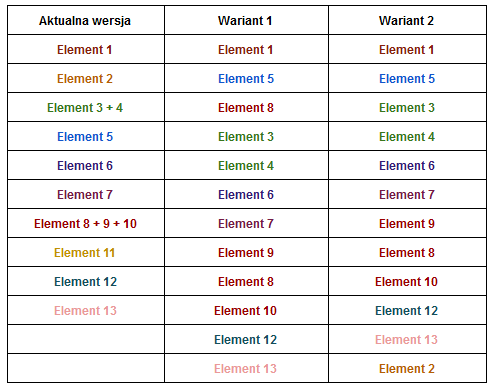

Drugą zmianą, którą wprowadziliśmy w sklepie, była zmiana kolejności wyświetlania elementów na karcie produktu, i to właśnie ta zmiana była kluczowa. Na potrzeby testów ustaliliśmy Wariant 1 oraz Wariant 2 z nowym rozmieszczeniem tych elementów oraz wykorzystaliśmy aktualną wersję ich rozmieszczenia. Ułożenie elementów w każdej z opcji było następujące:

Reasumując, jeden z ustalonych wariantów różnił się od wariantu bazowego sposobem wyświetlania zdjęć. Drugi natomiast sposobem wyświetlania zdjęć oraz kolejnością rozmieszczenia danych elementów na karcie produktowej.

Podczas przeprowadzania testów A/B warianty rozmieszczenia elementów na stronie towaru były wyświetlane użytkownikom losowo, a wprowadzenie tego typu rozwiązania nie było łatwe. Jeżeli Użytkownik wyświetlał już daną stronę, przy kolejnej wizycie w sklepie należy mu wyświetlić dokładnie tę samą wersję strony. W innym przypadku wyniki przeprowadzonego przez nas testu A/B nie byłyby wiarygodne. Do tego dochodziły inne aspekty, m.in. jednoczesne obsługiwanie różnych bibliotek do wyświetlania zdjęć i filmów oraz raportowanie. Udało nam się połączyć wszystkie te elementy i zrealizować zamierzony cel.

Wyniki – konwersja wyższa o ponad 13%!

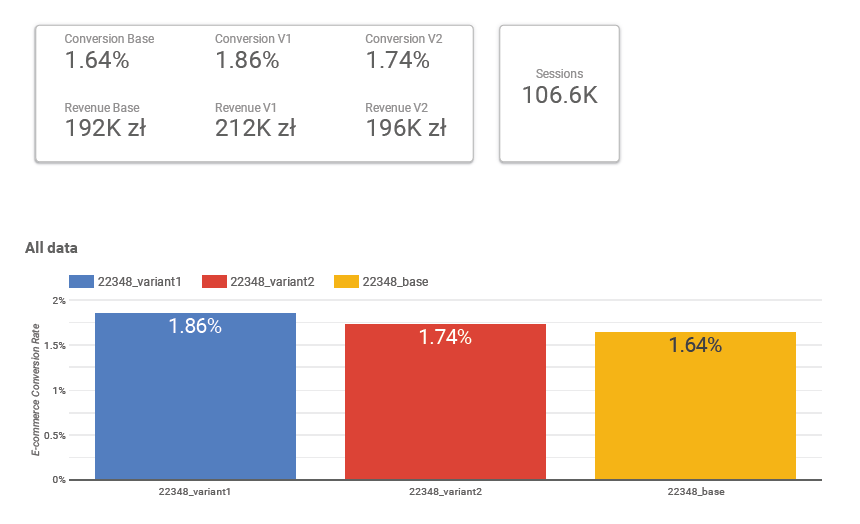

W ramach podsumowania przeprowadzonych testów A/B przygotowaliśmy trzy raporty w Google Analytics. Pierwszy raport obejmował swym zakresem cały sklep. Drugi był raportem dla sesji rozpoczynających się od strony towaru. Trzeci natomiast – raportem dla sesji rozpoczynających się od strony kategorii. W Google Analytics stworzyliśmy także segmenty umożliwiające szczegółowe badanie zachowania użytkowników w sklepie. Dodatkowo stworzyliśmy także raport w Google Data Studio.

Ogólne wyniki:

Najlepszy Wariant rozmieszczenia elementów na stronie towaru osiągnął takie oto wyniki:

- W kontekście całego sklepu:

- konwersja +13,4%

- przychody +10,3%

Jak widać na powyższych danych, najlepszy wariant wygenerował konwersję o ponad 13% wyższą i przychody o ponad 10% większe od tych, które wygenerowała bazowa wersja.

Szczegółowe wyniki przeprowadzonych testów A/B wyglądają następująco:

Chciałbyś dowiedzieć się jeszcze więcej o testach A/B?

A może chciałbyś przeprowadzić takie testy w swoim e-commerce?

Zapraszamy do kontaktu z nami. Chętnie odpowiemy na Twoje pytania!

Skontaktuj się z nami i poproś o testy A/B